Inference-Time Scaling for Generalist Reward Modeling 论文解读

摘要

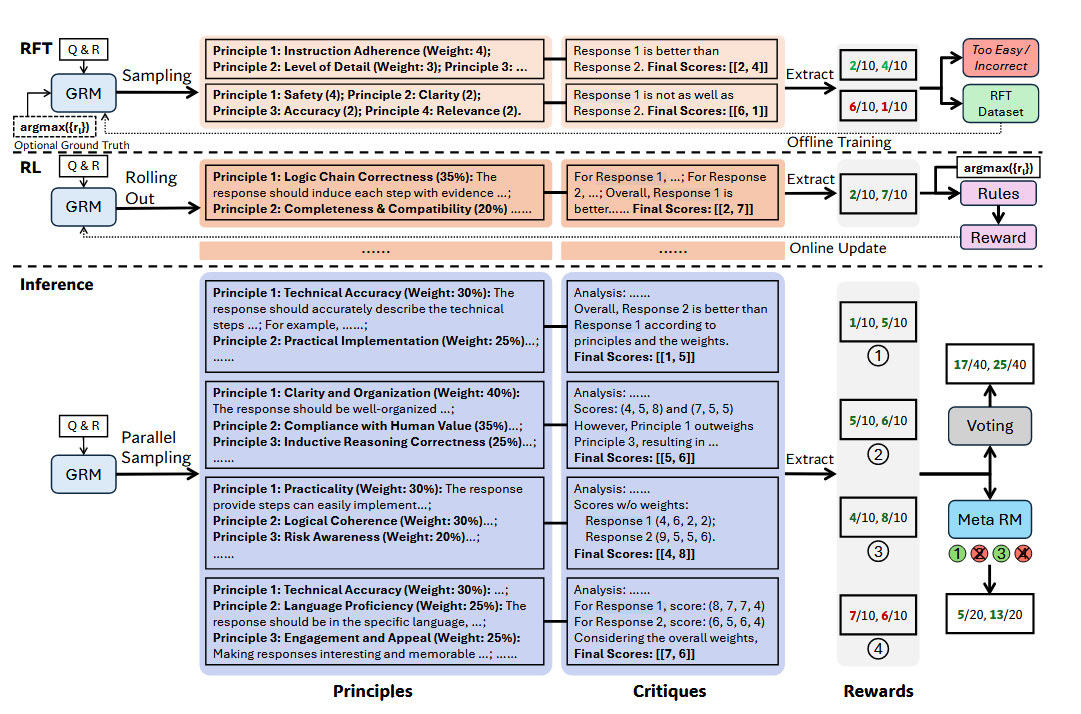

本文解读的是 DeepSeek-AI 与清华大学团队联合发布的论文《Inference-Time Scaling for Generalist Reward Modeling》。该研究致力于提升大语言模型(LLM)在推理阶段的奖励建模能力,提出了全新训练方法 SPCT(Self-Principled Critique Tuning),并构建了通用奖励模型系列 DeepSeek-GRM。论文核心思想在于:模型可自生成评估原则(Principles)与评语(Critiques),结合多轮采样与 元奖励模型(Meta RM) 投票,显著提升奖励输出质量,而无需增加模型参数。实验结果显示,DeepSeek-GRM 在多个奖励建模基准上超越现有主流模型,且推理阶段的扩展效果优于单纯扩大模型规模所带来的训练增益。

引言

在 RLHF(Reinforcement Learning from Human Feedback)已成为大语言模型主流后训练范式的背景下,如何获取稳定、准确的奖励信号仍是构建高质量语言模型的关键难题。传统的奖励模型多依赖静态评分函数和有限的任务场景,难以在推理阶段动态适应多样输入和复杂需求。

《Inference-Time Scaling for Generalist Reward Modeling》这篇论文关注的核心问题是:能否在推理阶段,通过增加计算资源和优化方法,实现奖励模型行为的可扩展性与高质量输出?

为此,作者引入了“生成式奖励建模”(Generative Reward Modeling)和“自原则化评语调优”(SPCT)机制,使模型不仅能评价多个答案,还能在推理时自适应生成评价标准与评语。结合并行采样和 Meta Reward Model 投票机制,最终构建出性能优异的 DeepSeek-GRM 套件,为后续的通用奖励系统、模型评估与 RL 反馈机制提供了新的技术路径。

作者指出了在实际应用中,使奖励模型(RMs)既具备通用性,又在推理阶段具备有效的可扩展性,面临的主要四个需求,或者说是挑战。

| Challenge / Demand | Description | Proposed Solution | |

|---|---|---|---|

| (1) | Input Flexibility | RMs should handle single, paired, and multiple responses as input | Adopt Pointwise Generative Reward Modeling (GRM) to support all input formats with unified scoring |

| (2) | Domain Generalization & Behavioral Adaptivity | RMs need to generate accurate rewards across diverse tasks and domains | Introduce Self-Principled Critique Tuning (SPCT) to train the model to generate adaptive principles and critiques using online RL |

| (3) | Inference-Time Scalability | RMs should produce higher-quality rewards as inference compute increases | Apply parallel sampling + voting at inference time to scale up reward quality |

| (4) | Effective Performance-Compute Scaling | RMs should learn to scale their reward quality with compute efficiently | Use a Meta Reward Model to guide the voting process and filter low-quality samples for better compute-performance tradeoff |

(1) 输入灵活性(Input Flexibility)

挑战:

当前许多 Reward Models(奖励模型)仅支持特定格式输入,例如单条或成对回应(paired responses),无法适应多种输入形式。

解决方案:

采用 Pointwise Generative Reward Modeling(点式生成式奖励建模,GRM),利用自然语言表示统一对单条、成对或多条响应的评分机制,提升输入处理的广度和灵活性。

(2) 跨领域泛化与行为可迁移性(Domain Generalization & Behavioral Adaptivity)

挑战:

奖励模型在面对不同任务、主题或领域时,通常无法生成一致且准确的奖励信号,缺乏泛化能力。

解决方案:

引入 Self-Principled Critique Tuning(自我原则化评语调优,SPCT),通过规则驱动的在线强化学习(rule-based online RL)训练模型自主生成“评判原则”(principles)与“自然语言评语”(critiques),提升其跨场景适应能力。

(3) 推理阶段可扩展性(Inference-Time Scalability: Compute-Driven Output Quality)

挑战:

奖励模型在推理阶段即使增加计算量(如采样次数),其输出质量常常提升有限,难以充分利用计算资源。

解决方案:

采用 并行采样(parallel sampling) 多次生成不同的原则与评语组合,再通过 投票机制(voting process) 汇总为最终奖励输出,使奖励质量随推理计算资源增长而提升。

(4) 可学习的扩展行为(Learned Scalability Behaviors: Performance-Compute Efficiency)

挑战:

模型不仅要在推理中“变好”,还应通过训练学会如何利用更多计算资源生成更优奖励,提升性能-计算比。

解决方案:

结合 SPCT 训练策略 与 Meta Reward Model(元奖励模型),引导模型在训练阶段掌握利用额外推理资源的策略性行为,并在推理时过滤掉低质量评分样本,从而实现更高效的推理可扩展性。

总体框架

RM架构

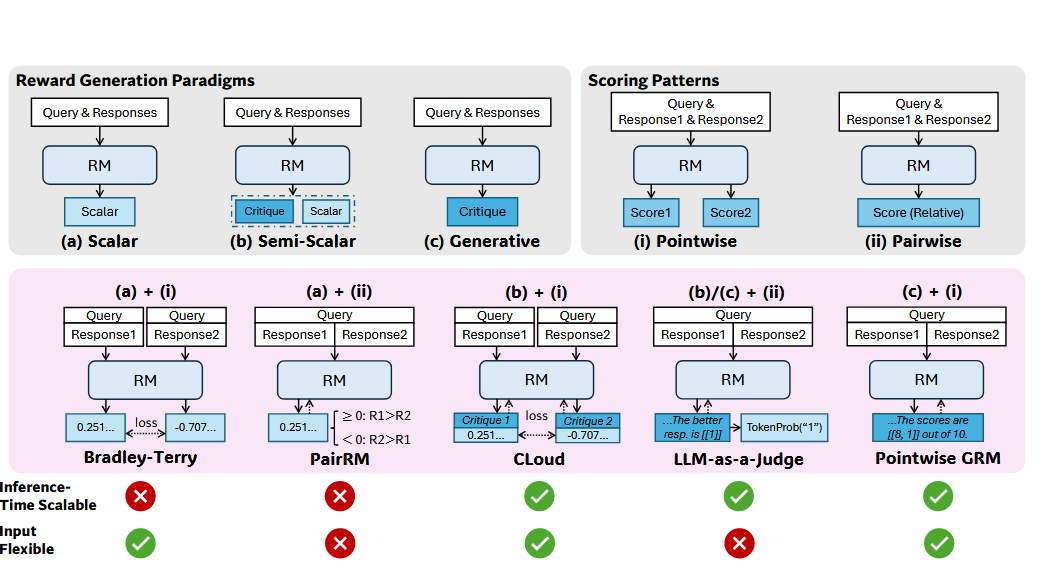

RM 的架构主要可以划分为两个维度

- 奖励生成范式(Reward Generation Paradigms)

- 评分模式(Scoring Patterns)

奖励生成范式(Reward Generation Paradigms)

| 类型 (Type) | 描述 (Description) |

|---|---|

| Scalar 标量式 | 直接输出一个数值型的奖励分数,如 0–10 分 |

| Semi-Scalar 半标量式 | 输出一段文本评语(critique)和数值奖励值(scalar) |

| Generative 生成式 | 仅输出自然语言形式的评语(critique),奖励值需通过后处理提取 |

评分模式(Scoring Patterns)

| 类型 (Type) | 描述 (Description) |

|---|---|

| Pointwise 点式评分 | 对每个回应单独评分,支持单条、成对或多条输入。 |

| Pairwise 配对评分 | 比较两个回应,选择更优者,无法处理多个回应 |

作者采用的奖励模型框架

作者在选择架构时候有以下两个方面的考量:推理阶段的可扩展性以及输入的灵活性

Inference-Time Scalability

To expand compute usage in inference time, we focus on sampling-based methods, which generate multiple sets of rewards for the same query and responses, and then aggregate the final reward. Thus, the inference-time scalability of RMs is determined by whether different rewards could be obtained from multiple sampling, where scalar RMs would fail in most cases due to the invariant generation of rewards

推理阶段的可扩展性,指的是模型在多次采样中是否能生成多样化的奖励信号,而标量奖励(Scalar)模型通常因输出恒定,难以扩展

Input Flexibility

and the input flexibility is defined by whether the RM supports rating single, paired, and multiple responses, where pairwise RMs could hardly rate single responses and usually require extra techniques (Jiang et al., 2023; Liu et al., 2025) to handle multiple responses.

输入灵活性衡量模型是否支持单条、成对、多条回应评分,Pairwise 模型对此支持较弱,处理多回应时需额外机制。

作者选用的模型是:Pointwise Generative Reward Modeling(点式生成式奖励建模,GRM)

- 奖励生成方式:Generative(生成式)

- 评分方式:Pointwise(点式)

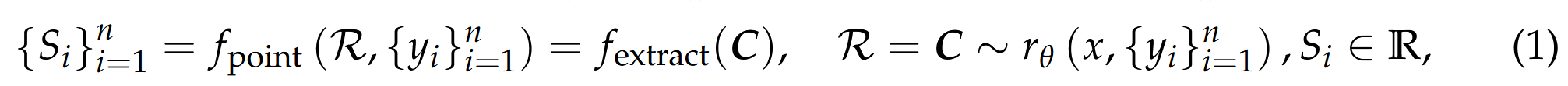

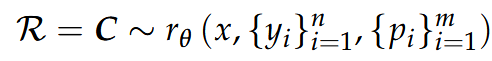

采用如下公式定义点式生成式奖励建模(GRM)过程:

Principles 评分原则

在开放领域缺乏明确评分标准的背景下,如何提升奖励质量成为通用奖励建模中的关键挑战

为此,可以引入评估原则(Principles),用作指导奖励生成的软规则,以替代传统的人工规则或标注。

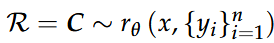

原本的公式(1)中的GRM

引入Principles则后更新为:

SPCT 微调阶段

在前文中介绍了:

- Pointwise GRM:支持对单条、成对、多条回应进行评分,解决了输入灵活性问题;

- Principles(评估原则):作为引导模型评分行为的标准,提升了奖励的质量与一致性。

然而,仅有 Pointwise 架构和原则引导并不足以形成泛化能力强、推理可扩展的奖励模型。模型若只是“接受原则”,而不能“主动构造原则”,在面对新领域或复杂任务时仍然会失效。

因此,作者提出 SPCT(Self-Principled Critique Tuning),它通过两阶段的训练过程,让模型具备以下能力:

- 在训练阶段学习自动构造合适的评价原则(Principles);

- 基于原则生成合理的评语(Critiques);

- 提取高质量评分(Scores),最终统一在 Pointwise GRM 框架下完成评分。

换句话说:

SPCT 是连接“Pointwise GRM 架构”与“Principles 指导”之间的训练桥梁,它让评估逻辑不再依赖外部输入,而是模型通过训练“学会评分的方式”。

SPCT 包含两个阶段:

第一阶段: 冷启动:Rejective Fine-Tuning(RFT)

该阶段为离线微调,旨在利用已有 ground truth 评分判断模型输出的好坏,从而筛选出高质量样本构建训练集。

使用 Pointwise GRM 架构统一处理任意数量的回应 , 每个问题及回应组会进行

- 若模型预测与真实评分不一致 → 拒绝;

- 若所有采样都预测正确 → 太容易也拒绝;

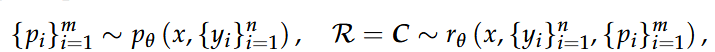

定义一组预测的奖励

其中,

同时,为弥补初始模型能力不足,引入 Hinted Sampling,将最优 index 明示注入 Prompt,提高对齐准确率,然而作者发现 Hint 模式可能导致“评语偷工减料”,特别是在逻辑推理任务上;

在 Rejective Fine-Tuning 阶段筛选出高质量样本后,进一步通过离线监督学习(offline supervised training)对 GRM 模型进行初步训练,使其具备基本的评分能力。虽然该阶段在结构上未被单独划分为一个训练阶段,但其作用关键,直接作为后续强化学习的模型初始化。

第二阶段:Rule-Based Online Reinforcement Learning

在 Rejective Fine-Tuning 提供初始结构能力后,SPCT 的第二阶段使用 基于规则的在线强化学习(Rule-Based RL) 对 GRM 进行优化,训练目标是让模型“学会如何通过原则和评语准确评估最优回答”。

- 使用 GRPO 策略优化算法;

- rollout 时,GRM 根据输入生成:

- Principles(评分原则)

- Critiques(自然语言评语)

- Pointwise Scores(评分)

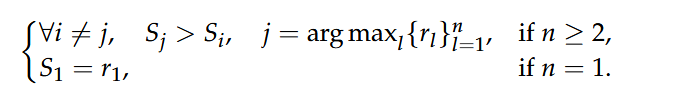

- 将预测评分与真实奖励进行比较,根据准确性给予正负奖励:

一般而言,第

SPCT 推理阶段

在完成 SPCT 的训练后,模型在推理阶段通过多次采样生成多组评分标准(Principles)与评语(Critiques),并据此计算响应的奖励得分。该阶段的目标是提升推理阶段奖励建模的可扩展性与鲁棒性。

推理流程概述

多次采样(Parallel Sampling)

对相同的输入 query 和响应组,进行次独立采样,生成对应的评分标准、评语和奖励得分。 奖励提取

从每轮采样结果中提取每个响应的奖励得分,其中 表示响应编号, 表示采样编号。 得分聚合(Voting)

将次采样的评分结果聚合得到最终得分 ,通常采用加和策略: 响应选择

最终通过选出评分最高的响应。

Meta Reward Model 引导

为避免部分采样质量较差,SPCT 引入 Meta Reward Model(元奖励模型)对每组采样结果进行质量评分,并筛选出前

模型实现细节

在具体实现的细节上,论文中给出一些说明,同时我也有一些问题

GRM | Principle Generator | Meta RM 各自的模型是什么?

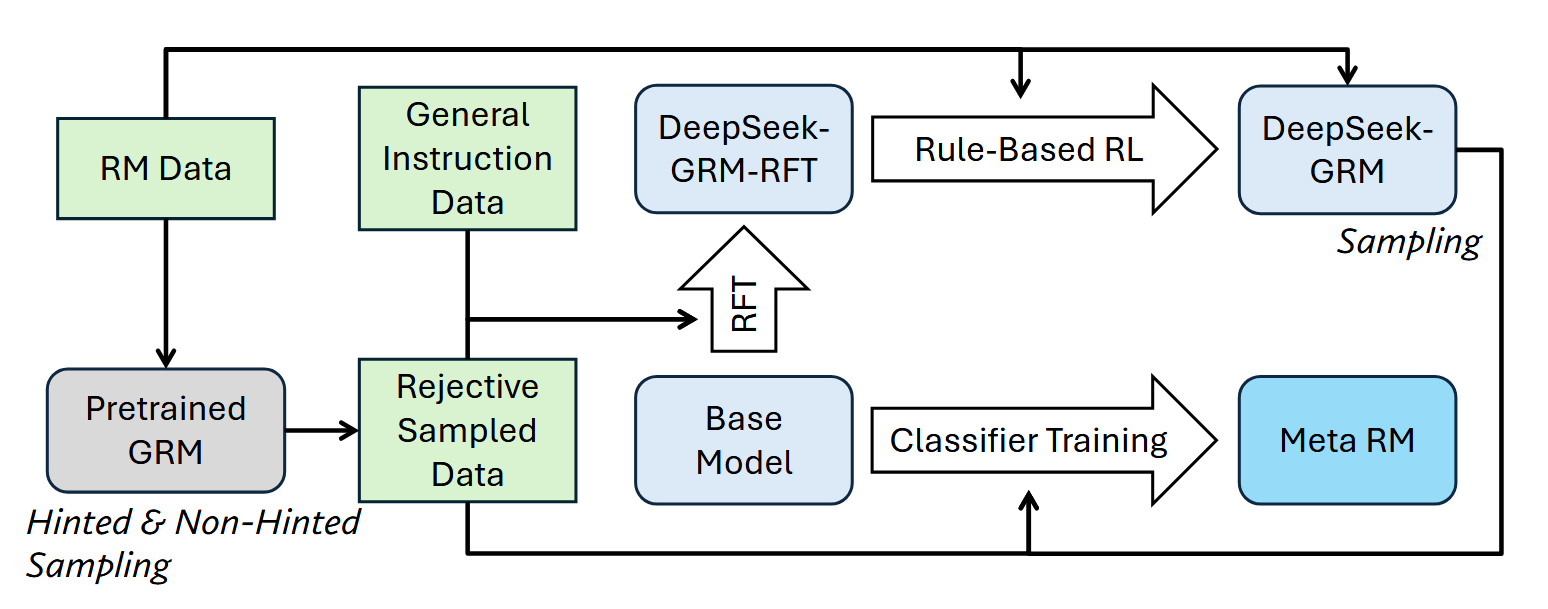

The derivation of DeepSeek-GRM models and the meta RM is illustrated in Figure 5. All DeepSeek-GRM models are trained from the pretrained version of LLMs.

| 模块 | 使用模型 | 功能 | 是否参与 SPCT 训练 |

|---|---|---|---|

| GRM | Gemma-2-27B(主版本),也在 V2.5/671B 上测试 | 生成 principles → critiques → rewards | ✅ 是主模型 |

| Principle Generator | 与 GRM 完全共享(= GRM) | 和 GRM 同模型,内部功能 | ✅ 同步训练 |

| Meta RM | 单独训练,基于 Gemma-2-27B | 过滤低质量 reward trajectory | ❌ 只参与推理阶段 |

Meta RM 是如何训练的 ?

1. 训练目标

Meta RM 被构建为一个 pointwise scalar reward model,旨在判断由 DeepSeek-GRM 生成的 principles 和 critiques 所对应的 reward 是否正确,进而对每个采样结果给出可信度评分。训练过程中使用二分类标签来监督模型学习 reward 的可靠性。

2. 数据来源

Meta RM 的训练数据来自两个主要部分:

- Rejective Fine-Tuning(RFT)阶段中 non-hinted sampling 所获得的轨迹;

- 推理阶段中 DeepSeek-GRM 所生成的采样轨迹。

该设计旨在覆盖足够的正负样本,并缓解训练策略与推理策略之间的分布差异。

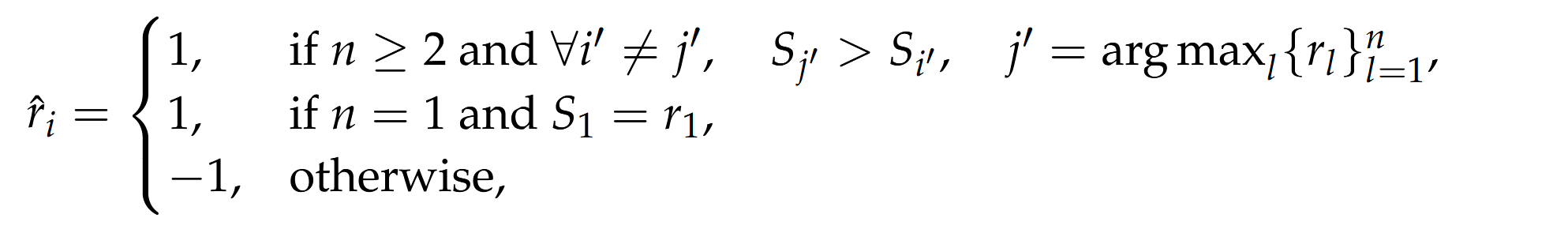

3. 标签构造

对于每条训练样本,标签的确定依据如下准则:

若样本中存在一个唯一的 ground truth 最优响应

,则当预测的 reward 满足如下条件,即被视为正确: 若为单响应场景,仅当预测值等于 ground truth 时视为正确。

否则,判为负样本。

该标签设计用于评估 reward 是否正确反映了响应的相对优劣。

4. 模型结构与训练损失

Meta RM 使用与主模型相同的 backbone(如 Gemma-2-27B),但仅输出标量可信度分数,不生成文本。

训练采用 Binary Cross-Entropy(BCE)损失函数:

其中

每条 query 是否独立生成 principles?采样的粒度是?

每条 query 都会根据其上下文和候选响应单独生成一组(多个)principles,用于指导 reward 的生成。principles 不是预定义的,也不是在多个 query 间共享的。

推理阶段 voting 是平均还是加权 ?

在推理阶段,默认使用 等权加总 的 voting 策略,即每次采样得到的 reward 分数被简单求和作为最终结果。对应的公式为:

其中,

若在vote排序时候出现评分相等的情况要如何处理?

To deal with ties of the predicted rewards for multiple responses, we shuffle the responses and determine the best response by arg maxi Si, where Si is the predicted reward for the i-th response after shuffling.

当多个 response 的最终 voting 分数

response 与 Principles 、 reward 等是同一个模型产生的吗?

尽管论文未明确指出 GRM 与响应生成模型完全分离,但通过“在 Gemma-2-27B 基础上通过 SPCT 微调得到 DeepSeek-GRM”的表述可以推断,GRM 是基于预训练语言模型单独训练的评分模块。它被设计为通用的评估器,与生成流程相互独立,专注于奖励评估和推理阶段的打分任务。

在对GRM进行优化的时候,生成response 的模型有没有也进行同步优化呢?

在训练 GRM 的过程中,生成响应的语言模型(如 Gemma-2-27B)并不会同步参与优化。GRM 是在固定的 response 输入基础上单独训练的评分模型,其优化过程完全解耦于生成模型,仅聚焦于打分能力的提升。这种设计有助于构建通用评分器,并能独立部署于任意 LLM 输出之上。

论文资源区块

- PDF:下载链接

- Title: Inference-Time Scaling for Generalist Reward Modeling 论文解读

- Author: YYk

- Created at : 2025-05-28 13:40:23

- Updated at : 2025-05-31 17:40:54

- Link: https://yykwd.github.io/2025/05/28/Papers/Inference-Time_Scaling_for_Generalist_Reward_Modeling/

- License: This work is licensed under CC BY-NC-SA 4.0.